近日,一款AI换脸的APP一夜之间火爆全网,用户只需要一张静态照片就能让自己实现孙猴子般“72变”,每一个人都可以通过一个APP实现“一夜成名”的梦想,让自己成为电影中的明星主角。

当然,AI换脸视频本身并非最新出现的技术。早在2017年,国外一个ID名为“DeepFakes”的Reddit论坛用户首次将自己制作的AI换脸视频发布在网络上。在被Reddit封杀后,“DeepFakes”直接开源了其AI换脸项目的代码,该项技术立刻风靡全球。在代码开源后,即使一个“菜鸟”也能在几个小时内做出一部换脸视频。人们为了纪念“DeepFakes”,就采用它的ID命名了AI换脸技术,称之为“DeepFakes”。

除了隐私问题,还将引发新的网络安全问题

DeepFakes本质上是一个未发生事情的视频,但却可以以假乱真,看起来非常真实。它主要是通过人工智能算法对照片库中大量名人照片进行训练,因此可以输出与真实视频毫无差异的内容。

DeepFakes会引发很多问题,比如隐私问题。那些定期收集到的大量普通用户数据,即使是在得到用户明确同意的情况下,大多数人也不知道网上有多少他们自己的照片。为此,国外甚至有人担心,一旦DeepFakes被用于政治操纵,将引发第三次世界大战。从“假新闻”中就能很容易看到这一点,这些虚假信息会故意制造谎言,然后在真相的掩护下传播。

劣币驱逐良币,设想下,如果我们无法检测到虚假视频,我们可能很快就会被迫不信任我们所看到和听到的一切东西。这不仅威胁到我们对政治制度的信心,而且从长期来看,威胁到我们对共同的客观现实的信心。

除此之外,DeepFakes还有一个被忽视的问题。那就是它们对网络安全的影响。在未来,DeepFakes将把网络攻击场景带入一个全新的层面,即图像,视频和音频可以通过数字方式进行深度伪造,以欺骗人们和组织。

今天的安全系统严重依赖监控视频和基于图像的生物识别安全。由于大多数漏洞都是基于社会工程的网络钓鱼攻击而发生的。不难想象我们很快就会看到“高保真”的网络钓鱼欺诈,即攻击者可以使用AI,社交工程和网络钓鱼,创建自动化、个性化的攻击内容。攻击者可以将DeepFakes视频以电子邮件附件分发,或者在YouTube等社交媒体上发布。一旦用户选择点击观看视频时,系统就会受到感染。同样,DeepFakes技术可用于规避基于摄像头的身份验证机制,例如通过Postident进行身份验证。

为应对钓鱼攻击,对于个人而言,需要增强自身安全防范意识,不轻信、不点击来源不明的链接或附件。对于企业而言,也可以通过其它一些方法,比如在员工电脑中安装管理软件,实时监控员工的一举一动。此外,为防止攻击者通过以PC终端为跳板入侵服务器,企业需要在主机侧增强安全防护,可在主机层部署类似青藤云安全这类企业的安全产品。

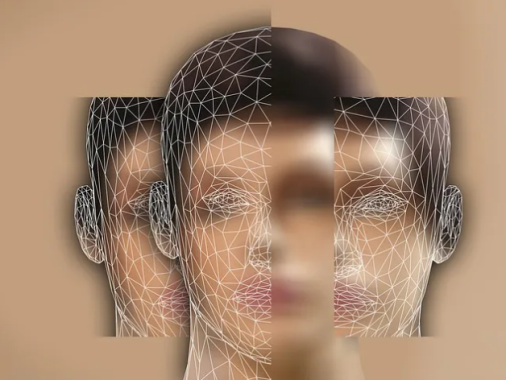

DeepFakes的工作原理和底层技术

“DeepFakes”背后技术来源于一种名为GAN(生成式对抗网络)的AI模型,它在2014年10月由前谷歌著名神级技术大咖Ian Goodfellow发布的一篇GAN论文而奠定了地位,GAN是当前人工智能学界一个最热门的研究方向。

当前的AI换脸,正是使用了GAN技术。该技术是通过“生成模型”和“判别模型”两个机器学习(ML)模型之间较量进行不断优化。生成模型负责对数据集进行训练,然后创建伪造视频内容,而另一个判别模型尝试进行伪造检测。伪造者创建赝品,直到另一个ML模型无法检测到伪造。训练数据集越大,伪造者越容易创建高质量的内容。这就是为什么前总统、好莱坞名人的视频经常出现在第一代DeepFakes中,主要是因为他们有大量公开的视频片段可以用来训练伪造者。

“以彼之长还施彼身”的解决之道

DeepFakes解决之道需要教育、技术和立法的相互结合。当然,最为重要的就是技术。因为当DeepFakes变得非常逼真时,只有机器才能分辨真假视频。虽然AI被认为是DeepFakes视频的罪魁祸首,但它也是目前为止应对DeepFakes视频最靠谱的技术。从检测发现到采取措施来消除DeepFakes带来的威胁,AI技术都是安全人员最好的办法。

值得庆幸是,目前基于AI技术的DeepFakes视频仍然存在一些缺陷,这让我们还有一些应对措施。比如眨眼,健康的成年人每2到10秒就会眨眼一次,一次眨眼需要十分之一秒。这对于正常视频而言非常正常,但是对于DeepFakes视频却非常难。因为当DeepFakes算法对人脸图像进行训练时,它依赖于互联网上可用的照片作为训练数据。即使是经常被拍照的人,网上也很少有闭着眼睛的照片。因为人们的眼睛大部分时间是睁开的,而且摄影师通常不会选择拍摄和发布那些闭眼的照片。

如果不训练人们眨眼的图像,DeepFakes算法就不太可能创建正常眨眼的人脸。与真人相比,DeepFakes视频中的人物眨眼的频率要低得多。因此在检测DeepFakes视频时,可以使用机器学习来检查视频中的眼睛睁开和闭上频率。例如,扫描视频的每一帧,检测其中的人脸,然后自动定位眼睛。然后,它利用另一个深度神经网络,利用眼睛的外观、几何特征和运动来判断被检测到的眼睛是开着还是闭着。这是检测虚假视频一个思路和手段。

当然,生成和检测假视频的竞争就像下棋一样。从理论上讲,GAN可以接受训练,学会如何躲避这样的取证。如果不法分子将所知道的检测技术都给GAN,它就能绕过所有这些检测。比如上文所说的,眨眼也一样可以添加到DeepFakes假视频中,包括使用闭着眼睛的人脸图像或视频序列进行训练。

写在最后

未来,虚假视频制作可能会做得越来越好,因此需要政府、企业及个人联合投入更多资源去研究检测DeepFakes假视频的技术。

据悉,目前美国国防高级研究计划局(DARPA)正在向研究人员投入资金,寻找更好的方法来认证视频。此外,为应对DeepFakes虚假视频,还有一个比较好解决方案是更好地教育普通大众,让大家明白眼睛所看到一切并非都是真的。这包括提高广大民众的素养,以便他们自身能够辨别一些假新闻。当然,虚假信息最大天敌就是真实信息。这就要求我们的记者成为更好的事实发现者。

新一代主机安全趋势研讨会|全国巡展(深圳站)

限额报名中,欢迎扫码参加

除此之外,可通过报名链接:

https://www.huodongxing.com/event/7507553789011